Dal codice al MIDI e oltre

L’anno dell’Intelligenza Artificiale (AI)

Il 2023 verrà ricordato probabilmente come l’anno dell’intelligenza artificiale, anche se sarebbe più corretto indicarlo come l’anno in cui si è ripreso a parlare del tema in maniera più consistente e continua. In effetti, l’argomento non è affatto una novità e se ne discute almeno dal 1955, anno della Proposal for the Dartmouth summer research project on artificial intelligence (McCarthy et al. 2006), il primo documento in cui si parla esplicitamente di “Artificial Intelligence” (d’ora in poi ‘AI’) e che pone le basi per lo svolgimento della conferenza proposta da John McCarthy e Marvin Minsky nell’anno successivo.

In questo documento, McCarthy utilizza l’espressione ‘Artificial Intelligence’ per definire “una macchina che si comporti in modi che sarebbero considerati intelligenti nel caso di un essere umano” (ibid., 11; tr. it. 10). Negli anni successivi si è assistito a momenti di grande interesse alternati ad altri di abbandono nei confronti del tema, per cui si è parlato di ‘primavere’ e ‘inverni’ dell’AI. Per quale motivo nell’ultimo anno è sbocciata una nuova ‘primavera dell’AI’ con toni e in alcuni casi una retorica che lascia intendere si tratti di una rivoluzione? Ci sono due aspetti di cui tener conto per comprendere questo crescente interesse.

Innanzitutto è necessario specificare che quando si sente parlare di chatbot (cfr. Glossario) come ChatGPT o Bard si fa riferimento a due sottocategorie dell’AI, ossia al machine learning e al deep learning[1]. In seconda istanza, nel campo di questo tipo di ricerca c’è stato un evento dirompente nel novembre del 2022: OpenAI, azienda statunitense che si occupa di sviluppare soluzioni di AI, rilascia pubblicamente ChatGPT, un chatbot basato su un LLM (Large Language Model, modello linguistico di grandi dimensioni, cfr. Glossario) in grado di interagire con l’utente attraverso il linguaggio naturale. Questo modello è in grado di generare testi coerenti con le richieste effettuate, rendendo molto difficile la distinzione tra un output generato dalla macchina e uno generato da un essere umano. Siamo di fronte a quella che chiamiamo intelligenza artificiale generativa, basata su sistemi progettati per produrre autonomamente nuovi contenuti, dati o output sotto forma di testo, immagini e suoni. A partire da quel momento si assiste al rilascio di altri chatbot come Bard di Google, ora diventato Gemini, o di applicazioni in grado di generare non solo testo scritto, ma anche testi parlati (text-to-speech), immagini (text-to-image) e suoni (text-to-speech, text-to-sound, cfr. Glossario alla voce “Text-to-…”).

Bisogna prestare molta attenzione a non farsi trascinare nella narrazione distopica che vede l’AI generativa come uno strumento che potrebbe portare alla sostituzione dell’intelligenza umana in molte attività intellettuali. Val la pena ricordare che almeno al momento in cui si scrive siamo molto lontani ancora dalla realizzazione della cosiddetta AI generale, ossia la tecnologia che permetterebbe di realizzare macchine straordinarie che pensano esattamente come noi. Queste macchine al momento restano confinate nella letteratura e nella filmografia di fantascienza o nel nostro immaginario. Ciò di cui ci occupiamo è invece riferito a un’intelligenza artificiale ristretta, ovvero tecnologie in grado di eseguire compiti specifici altrettanto bene o meglio di noi umani. Esempi di AI ristretta sono per esempio la classificazione delle immagini o il riconoscimento facciale.

Intelligenza artificiale a scuola, anche nell’ora di musica

L’AI non è il futuro, come spesso si legge, ma è già il presente, in quanto permea da tempo a diversi livelli il nostro vivere quotidiano. Introdurne l’uso consapevole in classe è quindi fondamentale non solo perché può aiutare gli studenti a consolidare competenze digitali per la cittadinanza, ma anche per potenziare il problem solving, riflettere su questioni etiche e, come vedremo, stimolare la creatività. Anche il DigComp 2.2 (Vuorikari 2022), che delinea il quadro delle competenze digitali che un cittadino europeo dovrebbe poter sviluppare, individua numerose competenze legate all’AI e indica chiaramente la necessità di acquisire una conoscenza di base del tema affinché i cittadini possano impegnarsi in modo competente, critico e sicuro con le tecnologie nuove ed emergenti[2]. In breve, se uno dei compiti della scuola è quello di sviluppare le competenze che permettano ai giovani di diventare cittadini attivi, tra queste un ruolo importante hanno le competenze digitali, ambito nel quale l’AI si è ritagliata una posizione di primo piano poiché è ormai di fronte agli occhi di tutti che essa rappresenta una vera e propria rivoluzione nell’ambito della diffusione e della produzione della conoscenza.

L’introduzione di nuove tecnologie nei processi educativi è spesso accompagnata da allarmismi e preoccupazioni che tendono a polarizzare il dibattito su posizioni pro o contro estreme. Ora, abbiamo già detto i motivi per i quali consideriamo urgente introdurre l’AI a scuola, ma desideriamo comunque anche precisare che tale urgenza non deve essere interpretata come semplice e superficiale entusiasmo per la novità di moda: è infatti nostra intenzione proporre un approccio critico e responsabile all’AI che non trascuri di trattare le problematiche etiche, sociali e legali che l’intelligenza artificiale solleva, di cui siamo convinti che ogni intervento in classe debba tenere conto[3].

Più concretamente, possiamo distinguere due filoni di attività. Il primo riguarda l’uso dell’intelligenza artificiale da parte dell’insegnante all’interno del proprio flusso di lavoro di preparazione delle lezioni. Il chatbot potrà quindi svolgere il ruolo di assistente sia nella creazione di materiale ex novo come esercizi o attività di studio di caso, ma anche fonte di ispirazione per personalizzare la lezione a partire da un dato argomento. Il secondo filone si concentra invece sull’uso dell’AI da parte degli studenti in prima persona, seppur con necessari accorgimenti dovuti a problematiche relative a privacy e dati personali, ma anche a questioni inerenti un uso attivo e non passivo dello strumento.

Per quanto riguarda questo secondo filone, nell’ora di musica l’AI è integrabile in moltissimi percorsi didattici. L’AI può essere utilizzata in attività di ricerca in ambito storico-culturale e di esercitazione del lessico tecnico-analitico. Offre inoltre possibilità tecniche specifiche quali la produzione di musica e suoni attraverso software text-to-sound o la conversione molto raffinata di file audio registrati o prodotti in diretta in file MIDI. Si può anche entrare più nello specifico per capire il ‘dietro le quinte’ dell’AI e addestrare un sistema per riconoscere i suoni con, ad esempio, Teachable Machine. Tutte queste sono attività interessanti che ci ripromettiamo di sperimentare con il tempo. Nell’elaborare l’idea della presente esperienza non siamo però partiti da un tool, ma da un approccio didattico basato su due punti che rappresentano due priorità nella nostra attività didattica: strutturare percorsi didattici attivi, di carattere laboratoriale, che mettano al centro l’allievo, e dare ampio spazio alla composizione musicale per stimolare e sviluppare la capacità inventiva e la fantasia degli allievi[4].

Il prompt come strumento didattico

Prima di passare alla descrizione dell’esperienza didattica oggetto del presente articolo, è opportuno spendere qualche parola sul prompt ingegneristico[5], un elemento chiave dell’AI dalle valenze didattiche molto potenti.

Si è detto che un aspetto innovativo nell’uso dei LLM è quello dell’interazione uomo-macchina attraverso il linguaggio naturale. In questo contesto viene definito ‘prompt ingegneristico’ (d’ora in avanti ‘prompt’) l’insieme delle istruzioni fornite ad un modello di intelligenza artificiale per giungere alla generazione di un contenuto. Dal punto di vista didattico, la scrittura del prompt permette di perseguire moltissimi obiettivi educativi trasversali. Anzitutto sviluppano le abilità di scrittura, che interagendo con l’AI deve essere chiara, semplice, diretta, non ambigua, ma anche altamente dettagliata e specifica. Deve trattare elementi strettamente pertinenti al compito, fare esempi e, soprattutto, includere gli opportuni riferimenti al contesto per fornire il quadro di riferimento utile per l’interpretazione del compito.

Il motivo per il quale il prompt deve avere queste caratteristiche è puramente tecnico. I modelli linguistici di grandi dimensioni non hanno la capacità di ragionare o comprendere come il cervello umano, ma sono in grado di effettuare in modo molto efficace l’elaborazione statistica dei testi sfruttando enormi quantità di dati, potenza di calcolo e algoritmi avanzati. Non traggono quindi vantaggio dalla comprensione semantica, ma possono ottenere risultati notevoli concentrandosi sulla struttura formale dei testi. Per questo è solo ripetendo le istruzioni e contestualizzandole con informazioni che in una conversazione umana sarebbero ridondanti che si aiuta l’AI a cercare i dati giusti. Strano a dirsi, ma il prompt deve anche essere nel tono pertinente alla risposta cercata: se opportunamente guidata, l’AI riesce a ‘capire’ se deve usare un tono informale o formale o se sta interagendo con un bambino o con un adulto. Inoltre, è importante tenere presente che il primo prompt è solo il punto di partenza al quale devono seguire sub-prompt per migliorare e correggere il primo risultato. Ed è proprio in questo dialogo con l’AI che entra in gioco anche la conoscenza del lessico musicale specifico, che deve necessariamente essere usato per ottenere i risultati desiderati. In sintesi: più chi interroga il sistema di AI è competente nella materia oggetto dell’interrogazione e più sa usare le tecniche di comunicazione appropriate, più avrà probabilità di ottenere dal sistema di AI risposte utili. Non a caso lo scrivere prompt sta diventando un vero e proprio ‘mestiere’.

L’idea: comporre musica con l’aiuto dell’AI

L’idea di comporre musica usando sistemi di AI può dare origine a un equivoco: quello che la macchina ‘faccia il lavoro’ al posto dell’essere umano. Se si parte da questo presupposto, peraltro poco interessante dal punto di vista didattico, presto si rimane delusi. Come d’altra parte la generazione di testi e di immagini ha già ampiamente mostrato, l’idea che la macchina svolga il lavoro al posto dell’essere umano confezionando prodotti finiti è solo frutto delle narrazioni mediatiche e dell’immaginario proposto dalla fantascienza. Al contrario, dopo lo stupore generato dalle risposte ai nostri primi prompt, presto giunge la noia, vista la ripetitività e la banalità delle risposte. L’AI, infatti, non può sostituire l’intelligenza umana e questo è vero soprattutto nelle attività artistiche, che si basano sull’inventiva, sulla fantasia e sull’immaginazione, ovvero su presupposti opposti a quello che fanno i sistemi di AI, che di fatto non fanno altro che rielaborare schemi e contenuti sui quali sono stati addestrati.

Non si creda però che l’AI non sia utilizzata in campo artistico. Al contrario, sono molti gli artisti che stanno sperimentando l’AI nei modi più diversi. Rimandando in altra sede una discussione più ampia su questo punto, qui tratteremo solo dell’idea che ha ispirato l’attività che ora andiamo a presentare, che è semplicissima: interrogare l’intelligenza artificiale per trovare stimoli, idee e ispirazione per comporre musica originale.

Cercare modi per stimolare la propria creatività è una pratica tutt’altro che nuova. Pensiamo al ‘motivo BACH’ usato da Johann Sebastian Bach in varie composizioni, come nel soggetto della fuga nell’ultimo Contrapunctus de L’arte della fuga, e poi utilizzato da altri compositori nei secoli successivi. Si tratta di un motivo generato interpretando le lettere del nome ‘Bach’ come nomi di note nella nomenclatura tedesca: B = Sib, A = La, C = Do, H = Si. Questo è solo il caso più famoso di una tecnica, quella dei crittogrammi musicali (Sims 1979), i cui primi esempi sono stati riscontrati addirittura in Josquin Desprez per arrivare fino ai giorni nostri con, ad esempio, Pauline Oliveros che, per rendere omaggio a John Cage, nella composizione Dear.John: A Canon on the Name of Cage (1986) ha usato le note C, A, G, E (Do, La, Sol, Mi) (Polansky 2011). Parlando di John Cage subito viene in mente la sua ‘musica aleatoria’ e, ancora più calzante al nostro caso, il suo uso del libro classico cinese dell’I-Ching (Libro dei mutamenti) per comporre musica. I-Ching utilizza un simbolo esagrammatico per generare divinazioni sulla base di eventi casuali quali il lancio di monete o la combinazione di steli di millefoglie. Una composizione basata su questa tecnica è Imaginary Landscape No. 4 (1951) (Nicholls 2002, 229). Anche Mozart si è divertito a inventare musica usando elementi casuali: a lui è attribuito un libretto intitolato Musikalisches Wurfelspiel (Gioco musicale dei dadi) dove è illustrato un gioco che permette di comporre musica attraverso il lancio di dadi (Mozart 1793). Anche il rapporto tra matematica e note è un elemento assai sfruttato dai compositori: dalla musica stocastica di Xenakis (Restagno 1988, 100) fino alla sezione aurea e le serie di Fibonacci di Bela Bartok (Lendvai 1982, Bayley 2001, 100) o, in tutt’altro ambito, dei Tool (Alessandrini 2019, 44-45), i giochi matematici e combinatori su cui si sono sbizzarriti i compositori sono innumerevoli. E che dire delle tecniche di elaborazione melodica che si affidano alla versione inversa, retrograda o retrograda inversa di una melodia data? Si potrebbe andare avanti ad elencare casi simili, ma già da questi pochi esempi è evidente che i compositori sono molto creativi non solo nel comporre musica, ma anche nel trovare modi fantasiosi e a volte strampalati per stimolare l’inventiva musicale. Non ci dobbiamo stupire dunque se al giorno d’oggi sempre più spesso i compositori stiano interrogando l’intelligenza artificiale proprio per trovare idee nuove – idee che, forse, a un essere umano non verrebbero mai in mente.

Dall’idea al progetto didattico

Per sviluppare l’idea esposta nel paragrafo precedente è stato necessario risolvere preventivamente due importanti nodi problematici. Il primo riguarda il fatto che il materiale ottenuto interrogando l’AI doveva essere modificabile e sviluppabile a fini compositivi in modo semplice e accessibile in contesto scolastico. Per questo si è pensato di lavorare su file MIDI, un formato che permette di essere facilmente gestito a lezione attraverso l’uso delle DAW[6]. Il secondo nodo riguarda invece la necessità di dirigere i modelli di AI su risposte il più possibile poco articolate, imprevedibili, strambe e, soprattutto, non marcate stilisticamente. La risposta a queste esigenze progettuali è venuta dall’idea di chiedere ai modelli di AI di scrivere codici che potessero generare file MIDI melodici. Questo costringe il prompt a concentrarsi sui parametri musicali quali note, durate e altezze, e meno su suggestioni contenutistiche quali “allegro”, “triste”, “romantico” etc.. In questo modo si ottiene la generazione di elementi sonori poco ‘sensati’ e bizzarri, e proprio per questo stimolanti per l’inventiva e l’immaginazione.

L’idea di coniugare l’AI con l’attività di coding è nata anche perché l’intenzione di integrare l’AI nelle lezioni di musica è maturata parallelamente alla progettazione della partecipazione all’appuntamento annuale della Code Week 2023[7]. Tra AI e la programmazione informatica c’è infatti un legame molto stretto: è noto che i chatbot di AI sono un ausilio molto sfruttato dai programmatori, che li utilizzano per scrivere blocchi di codice.

Tutti questi elementi hanno portato alla definizione del punto di partenza del nostro progetto didattico: interrogare un sistema di AI chiedendo di scrivere un codice per creare file MIDI che costituiscano idee musicali con le quali avviare un processo compositivo. Come vedremo, nel percorso progettato entrano poi in gioco altri due momenti importanti: la creazione di immagini attraverso un sistema di AI e l’uso della DAW per comporre musica. L’attività che andiamo a presentare tocca dunque vari ambiti del sapere e introduce vari contenuti, invita a sperimentare in prima persona varie risorse digitali e sviluppa vari tipi di competenza, il tutto in modo laboratoriale. Si tratta dunque di un’attività che centra parecchie finalità didattiche disciplinari (uso del linguaggio tecnico, composizione musicale) e trasversali (introduzione alla programmazione informatica e all’uso dei sistemi di AI, produzione multimediale). In generale si tratta di un’attività che promuove allo stesso tempo l’espressività artistica e la curiosità da un lato, e, dall’altro, l’attivazione del pensiero critico sul mondo digitale che ci circonda.

Le fasi dell’attività didattica

Introduzione all’AI

L’attività è stata annunciata alla classe durante una lezione di un’ora. Qui si è descritto il percorso progettato. La classe, una terza, proveniva da un’esperienza di composizione musicale con la DAW sviluppata durante lo scorso anno scolastico e dunque ha capito bene l’idea generale di ottenere dall’AI un file MIDI da rielaborare con una DAW. Come proponevamo di arrivare a questa fase compositiva, però, come ci aspettavamo, è rimasto avvolto nel mistero, in quanto la classe non aveva mai usato sistemi di AI e neppure aveva competenze di programmazione informatica, dunque non aveva chiaro cosa significassero ‘intelligenza artificiale’, ‘programmazione’, ‘codice’ e così via. L’idea ha però suscitato parecchia curiosità su cui i docenti hanno fatto leva per proporre due lezioni introduttive in cui spiegare che cos’è l’AI generativa, esemplificare l’uso di alcuni strumenti, in particolare i chatbot text-to-text, approfondire i concetti di ‘addestramento’ (cfr. Glossario) e di prompt, ed infine riflettere sulla reale utilità di questi sistemi, sul rischio di errori e dei bias (cfr. Glossario) e sui problemi legati alla proprietà intellettuale dei contenuti generati. Quando si porta l’AI in classe, questa premessa è necessaria e doverosa: visto la delicatezza e l’attualità del tema è importante affiancare le spiegazioni tecniche con una riflessione critica che porti alla consapevolezza dei ragazzi la reale portata del ruolo dell’AI nel mondo odierno.

Fase 1 – Creazione del file MIDI (e l’importanza del prompt)

Dopo queste lezioni generali, si è passati alla parte operativa del progetto. Le istruzioni per gli allievi sono state distribuite sul web (cfr. Comporre con l’AI: dal codice al MIDI e oltre 2022). La prima fase, descritta nella scheda allegata “Fase 1” (cfr. Documentazione), inizia con la richiesta al chatbot di scrivere un codice con il quale creare un file MIDI. Naturalmente il prompt deve presentare anche indicazioni sulle caratteristiche musicali del file MIDI. Il codice così ottenuto va copiato in un ‘editor di testo e di codice sorgente’ (source code editor, d’ora in avanti semplicemente ‘editor’, cfr. Glossario) per verificarne la correttezza formale. In caso di errori, si torna al chatbot per correggere; se invece il codice risulta corretto, si aggiunge una stringa di testo che permette all’editor di creare il file MIDI. Il file così ottenuto viene importato in una DAW per essere ascoltato e valutato. Al primo passaggio, la maggior parte delle volte il risultato non è soddisfacente. È quindi necessario tornare alla chatbot e all’editor e proseguire l’interrogazione dell’AI per cercare di migliorare tale risultato. È anche possibile, con poche e semplici istruzioni, imparare a modificare direttamente il codice.

In questa fase, dunque, i ragazzi sono impegnati in un costante andirivieni tra chatbot, editor e DAW, alla ricerca di un risultato soddisfacente. Un ruolo centrale spetta al prompt, che, come abbiamo già detto, richiede lo sviluppo di abilità molto raffinate.

Come si noterà dalla scheda “Fase 1”, il primo prompt è guidato. Questo perché, proprio per le caratteristiche del prompt, l’avvio di un attività così complessa come la presente non si può improvvisare. L’inizio del primo prompt è dunque stato studiato dai docenti e proposto ai ragazzi: “Puoi scrivere una melodia su un file MIDI utilizzando Python con la libreria Mido?”. Si tratta di prompt che include in una riga le seguenti informazioni:

- “melodia”: indica il risultato desiderato dal punto di vista musicale;

- “file MIDI”: indica l’obiettivo finale: ottenere un file MIDI;

- “Python” (cfr. Glossario): indica in quale linguaggio di programmazione si desidera che il codice sia scritto;

- “Libreria Mido” (cfr. Glossario): indica da quale libreria il codice debba prendere i suoni per creare il file MIDI.

La seconda metà del primo prompt è libera. Dopo questo primo prompt, nel resto del dialogo con il modello di AI attraverso i sub-prompt i ragazzi sono stati lasciati liberi.

Questa parte del percorso non solo è molto complessa in sé, ma presenta molti passaggi ancora oscuri ai ragazzi. Per questo, una lezione di due ore è stata dedicata a produrre file MIDI in plenaria. La procedure è stata inizialmente gestita dai docenti e solo in un secondo momento da alcuni alunni volontari. In questo modo si è mostrato ai ragazzi l’ambiente digitale di lavoro, lo svolgimento della procedura e il modo di modificare direttamente il codice. Si è colta l’occasione per sottolineare come, nella programmazione come nella produzione artistica, siano fondamentali non solo la fantasia e l’inventiva, ma anche la perseveranza e la determinazione, necessarie non solo per trovare l’idea soddisfacente, ma anche per risolvere i problemi tecnici e i malfunzionamenti che inevitabilmente insorgono quando si ha a che fare con le tecnologie.

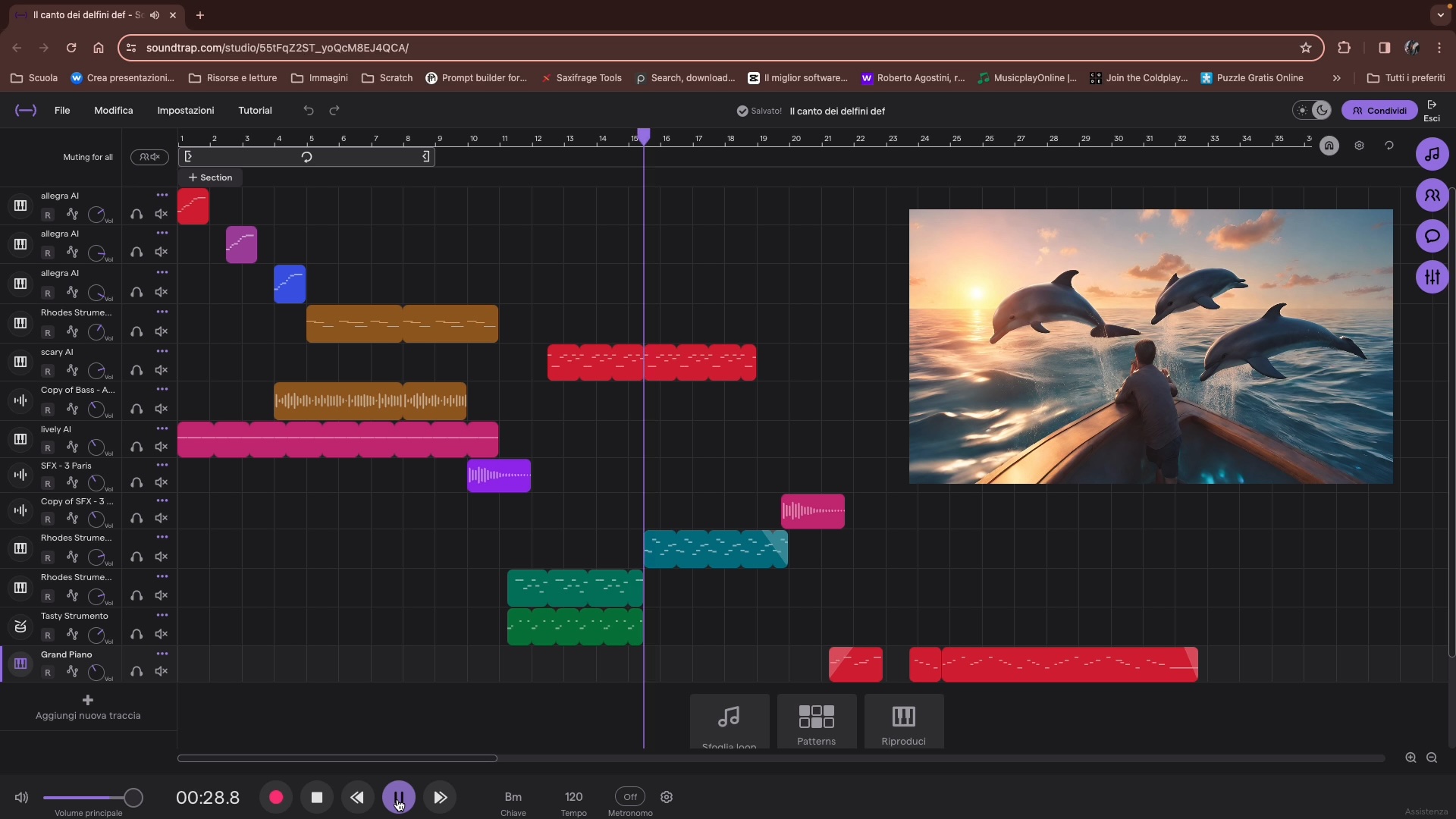

La lezione successiva, quella organizzata all’interno della EU Code Week, è stata finalmente la volta in cui i ragazzi hanno lavorato in autonomia. La classe è stata suddivisa in gruppi di lavoro. Ciascun gruppo aveva a disposizione due computer: uno dedicato alla scrittura di un diario di bordo in un documento di testo condiviso usando Google Workspace for Education, la piattaforma in uso nella scuola, e l’altro impostato ad hoc per usare il sistema di AI. Va sottolineato che l’uso dell’AI a scuola pone grossi problemi di privacy: gli strumenti che danno accesso all’AI non possono essere usati dai minori di 13 anni e comunque si tratta di strumenti che prevedono un account e la profilazione, dunque non utilizzabili a scuola. Per risolvere questo problema, i docenti hanno predisposto l’ambiente di lavoro in alcuni computer della scuola. L’accesso a tale ambiente era possibile solo entrando in un profilo specifico le cui credenziali erano note solo ai due docenti titolari del progetto. I ragazzi hanno dunque trovato l’ambiente di lavoro – quello mostrato nelle lezioni in plenaria – già predisposto, ma usabile solo sotto la supervisione dei docenti. Tale ambiente prevedeva il chatbot di AI Bing di Microsoft usata attraverso il browser Edge (ancora non era stato distribuito Copilot) e l’editor Google Colab. La scelta della chatbot è caduta su Bing perché questa risorsa si è rivelata la migliore nella creazione dei codici rispetto alle altre (il confronto è stato fatto con la versione gratuita di ChatGPT e Google Bard). Google Colab è stato scelto perché, essendo una risorsa inclusa in Google Workspace, può essere facilmente gestita dai docenti della scuola. L’ambiente di lavoro prevedeva anche una DAW. Qui la scelta è caduta su Soundtrap, al quale i ragazzi potevano accedere usando l’account istituzionale perché l’istituto ha sottoscritto un abbonamento alla versione Education di questa piattaforma.

La lezione di avvio delle attività organizzata all’interno della EU Code Week 2023 è testimoniata nel primo video allegato (cfr Documentazione). Abbiamo colto l’occasione della EU Code Week 2023 anche perché è altamente motivante per i ragazzi, che uniscono la consapevolezza di sperimentare un percorso didattico innovativo con la partecipazione ad un’iniziativa degli echi internazionali. Nel video è possibile vedere l’organizzazione in gruppi di lavoro, qualche schermata dell’ambiente di lavoro digitale, le varie fasi di lavoro ed anche una breve testimonianza di un momento in cui alcune ragazze modificano il codice. Nella parte finale, il video mostra il lavoro ottenuto dai vari gruppi al termine della lezione. Come si noterà il risultato è eterogeneo: a file ‘grezzi’ molto semplici si affiancano progetti che già stanno rielaborando i file MIDI ottenuti. Sottolineiamo che questo non significa che esistano gruppi più o meno ‘bravi’: tutti i gruppi si sono impegnati e hanno lavorato in modo molto serio, ma spesso quando si usano reti, codici e AI si verificano problemi tecnici che hanno bisogno di tempo per essere risolti, soprattutto quando si usano le reti sempre molto deboli delle scuole. Per questo, a questa lezione se ne è affiancata una seconda per permettere a tutti di migliorare il proprio risultato e coinvolgere gli assenti.

Fase 2 – Comporre, ma anche illustrare

Il progetto è proseguito con le fasi di composizione musicale vera e propria. Per rendere meno astratta la fase di composizione, è nostra abitudine consigliare ai ragazzi di farsi guidare da un’intenzione comunicativa. Comporre musica significa usare un linguaggio ed è importante partire dal senso, chiedendosi anzitutto che cosa si desidera esprimere attraverso la musica.

Un modo per incoraggiare i ragazzi ad assumere questo approccio è quello di chiedere di assegnare un titolo alla propria composizione. Il titolo può essere naturalmente cambiato durante il percorso – cosa che peraltro è successa, come ci hanno riferito i gruppi di lavoro –, ma intanto funziona da punto di riferimento. Per questa esperienza abbiamo però pensato di aggiungere al titolo una suggestione visiva e, per farlo, siamo tornati a parlare di intelligenza artificiale.

Esistono numerosi servizi online che consentono di generare immagini a partire da prompt, perlopiù in inglese, ma non mancano anche applicazioni che consentono l’interazione in italiano. Dall-E, Adobe Firefly, Midjourney e Stable Diffusion sono tra i più noti, ma presentano criticità per l’uso in classe in quanto richiedono la creazione di un account e l’accettazione di una privacy policy spesso incompatibile con l’età degli studenti della scuola del primo ciclo. Inoltre, la maggior parte di questi servizi richiede un abbonamento e consente di utilizzare un numero limitato di prompt gratuitamente. Per questo motivo la scelta dello strumento è ricaduta su Canva Education, disponibile presso l’Istituto, che consente agli studenti un uso in regola con la privacy e fornisce un generatore di immagini con un numero congruo di prompt per poter sperimentare.

Prima di dare indicazioni agli studenti, i docenti hanno introdotto il tema dell’intelligenza artificiale generativa nel campo visivo. Sono state mostrate diverse immagini create con sistemi di AI e confrontate con immagini reali, stimolando la riflessione sulla differenza tra reale, verosimile o artificiale. Successivamente ci si è concentrati sull’attività di realizzazione delle immagini suggerendo indicazioni per la scrittura dei prompt e mostrando la differenza tra immagini generate con prompt complessi o più essenziali. Alcuni studenti si sono scontrati con la difficoltà di realizzare immagini con contenuti inappropriati come ad esempio presenza anche minima di elementi che possano richiamare violenza; questa situazione ha dato l’occasione di riflettere su temi quali il machine learning, il deep learning, l’apprendimento supervisionato e in generale l’addestramento dei sistemi di AI.

Generalmente infatti i principali modelli linguistici di grandi dimensioni sono addestrati per evitare di fornire risposte inappropriate come ad esempio contenuti razzisti, sessisti, volgari o più genericamente offensivi. Per questo motivo anche le applicazioni di AI generativa non possono restituire immagini contenenti contenuti cosiddetti ‘tossici’ e l’unico modo per avvicinarsi al risultato desiderato consiste nell’elaborare alcuni stratagemmi. Un gruppo di studenti, ad esempio, di fronte all’impossibilità di generare uno scenario in cui fosse presente del sangue, ha indicato nel prompt di creare un’immagine in cui sul pavimento fosse presente della vernice rossa.

Raccontate, le fasi di lavoro sembrano razionali, ordinate e sequenziali, ma in realtà i gruppi hanno lavorato portandole avanti contemporaneamente in un allegro caos creativo: mentre sviluppavano la composizione sono a volte tornati a produrre file MIDI mentre in alcuni gruppi un componente ha continuato a lavorare sulle immagini costantemente fino all’ultima lezione. In questo contesto fluido e libero i docenti hanno allentato la richiesta di tenere un diario di bordo: per quanto utile dal punto di vista didattico, tenere un diario si stava tramutando in una zavorra che rischiava di cristallizzare e irrigidire le attività.

Le istruzioni date ai ragazzi per questa seconda fase sono consultabili nella scheda intitolata “Fase 2” (cfr. Documentazione). Come si noterà, si tratta di un documento molto meno dettagliato rispetto a quello della prima fase. Questo è dovuto essenzialmente a due fattori. Anzitutto, come abbiamo già notato, la classe aveva già esperienze di uso della DAW Sountrap per comporre. Tra l’altro avevano già seguito un percorso in seconda che li aveva portati a sonorizzare proprio delle immagini[8]. Dal punto di vista dei processi educativi, questo è un elemento chiave: lo sviluppo di progetti lunghi e articolati come il presente non può essere estemporaneo, avulso dal percorso didattico sviluppato quotidianamente, ma deve essere un’attività integrata nella programmazione della classe. In secondo luogo, va detto che per la produzione di immagini non abbiamo ritenuto necessario dare istruzioni troppo dettagliate, un po’ perché l’arte visiva non era il focus principale del percorso, un po’ perché la produzione di immagini attraverso l’AI è, in un certo senso, più facile e intuitiva rispetto a quella dei suoni. Non è nostra intenzione sminuire l’arte visiva, ma è un fatto che le persone siano abituate a descrivere ciò che vedono e abbiano anche sviluppato almeno un po’ la capacità di immaginare e fantasticare per immagini. Con i suoni le cose sono molto diverse: non solo le persone hanno una capacità analitica media più limitata del mondo sonoro rispetto a quello visivo, ma hanno anche una scarsa capacità di immaginare e fantasticare con i suoni. Questo divario è certo da attribuire a vari fattori legati alla contesto socio-culturale e ai percorsi scolastici, ma anche all’oggettiva difficoltà insite nell’uso della parola per descrivere le caratteristiche espressive della musica, molto più sfuggenti di quelle dell’ambito visivo.

Fasi finali

In generale, la classe intera si è fatta coinvolgere attivamente nelle attività. Le composizioni dei ragazzi sono state naturalmente di livello diverso, come è normale in qualsiasi attività scolastica. Le consegne sono state tutte generalmente rispettate, soprattutto quelle più importanti, che vincolavano il lavoro all’utilizzo di almeno un file ottenuto attraverso l’intelligenza artificiale, due loop originali elaborati usando gli strumenti incorporati in Soundtrap e un solo loop importato dall’archivio di suoni messi a disposizione dal software, che non poteva però essere usato per tutta la durata del brano. Per condividere i risultati ottenuti si è organizzato un piccolo concorso in cui ogni composizione è stata prima ascoltata e poi presentata alla classe dal gruppo che l’aveva elaborata.

La documentazione audiovisiva che abbiamo realizzato (cfr. Documentazione) raccoglie, oltre al già menzionato video sulla EU Code Week, un montaggio che raccoglie le immagini e le varie composizioni musicali e la presentazione di due composizioni. A proposito di questo terzo documento, va precisato che abbiamo chiesto a due gruppi di lavoro di riproporre la presentazione che avevano svolto di fronte alla classe al di fuori della lezione. Attenzione: i gruppi si erano preparati, ma la domanda della voce fuori campo alla fine non era stata concordata in anticipo.

Note

[1] Per approfondimenti, cfr. Glossario e Syzygy Group, Dr Paul Marsden & CHATGPT 2023.

[2] Cfr. “A2 Cittadini che interagiscono con i sistemi di IA”, in ibid., tr. it. p. 77.

[3] Cfr. Floridi 2022.

[4] Abbiamo approfondito questo tema in relazione all’uso delle tecnologie in educazione musicale in alcuni testi che trattano le attività coding. Cfr. Agostini e Izzo 2021, Agostini, Izzo e Nulli 2022; Agostini 2023. Per una visione più ampia e generale sul tema dell’ “invenzione musicale” segnaliamo il documento di presentazione del progetto di ricerca del Centro Studi Maurizio Di Benedetto intitolato Laboratorio di Pedagogia dell’Invenzione Musicale (LaPIM) (2022).

[5] Per approfondimenti, cfr. Glossario e Mollick e Mollic 2023.

[6] DAW è l’acronimo di Digital Audio Workstation (cfr. Glossario). Sull’uso didattico delle DAW, cfr. Agostini 2022.

[7] L’EU Code Week è un’iniziativa europea che si pone l’obiettivo di portare le attività di programmazione nelle scuole di ogni ordine e grado con un approccio didattico basato sul fare coinvolgente e divertente. Ogni anno, in autunno, viene lanciata la “EU Code Week”, ovvero un periodo in cui scuole e insegnanti possono aderire all’iniziativa proponendo un’attività che viene segnalata sul portale dedicato. Le adesioni sono migliaia e provengono dall’Europa e, in misura minore, da tutti i continenti.

[8] Si tratta di un lavoro svolto dallo studente del Conservatorio di Bologna Francesco Pascarella nell’ambito del suo tirocinio. Cfr. Pascarella e Agostini 2022.